Cẩn trọng trước thủ đoạn dùng công nghệ Deepfake ghép ảnh nhạy cảm tống tiền

Thời gian vừa qua, nhiều người dân đã phải làm đơn kêu cứu đến các cơ quan chức năng phản ánh về việc mình bị các đối tượng dùng công nghệ Deepfake ghép vào các hình ảnh, clip nhạy cảm với mục đích tống tiền. Trước tình trạng này, công an nhiều địa phương đã lên tiếng cảnh báo người dân.

Đối tượng lừa đảo ẩn danh trên mạng xã hội theo dõi “con mồi” trong thời gian dài, vờ gửi yêu cầu kết bạn, chia sẻ hoàn cảnh khó khăn, đáng thương của gia đình... Từ đó, các đối tượng đã lừa nạn nhân để lấy nội dung từ các tài khoản Facebook, Zalo... Cụ thể, đối tượng copy hình ảnh cá nhân được chủ tài khoản đăng công khai trên trang của họ, sử dụng Deepfake AI để ghép các hình ảnh đó thành clip hoặc hình ảnh nhạy cảm, gửi cho những người thân quen của nạn nhân nhằm mục đích khủng bố tinh thần, đe dọa, tống tiền qua mạng xã hội.

Cụ thể, đối tượng copy hình ảnh cá nhân được chủ tài khoản đăng công khai trên trang của họ, sử dụng Deepfake AI để ghép các hình ảnh đó thành clip hoặc hình ảnh nhạy cảm, gửi cho những người thân quen của nạn nhân nhằm mục đích khủng bố tinh thần, đe dọa, tống tiền qua mạng xã hội.

Trung tâm xử lý tin giả, thông tin xấu độc Việt Nam - VAFC đã nhận được phản ánh từ ông QTL về việc ông bị một số đối tượng phát tán trên mạng xã hội những hình ảnh giả mạo được cắt ghép, xử lý qua công nghệ Deepfake, với mục đích bôi nhọ danh dự, nhân phẩm và uy tín cá nhân.

Không những thế, các đối tượng này sau đó còn tiếp tục sử dụng những hình ảnh giả mạo để thực hiện hành vi tống tiền, yêu cầu ông QTL chuyển tiền vào ví điện tử của chúng và liên hệ qua email để xác nhận. Trung tâm xử lý tin giả, thông tin xấu độc Việt Nam cũng cho biết thêm, đơn vị đang phối hợp với các cơ quan chức năng để điều tra làm rõ vụ việc của ông QTL và xử lý nghiêm các đối tượng vi phạm theo quy định của pháp luật.

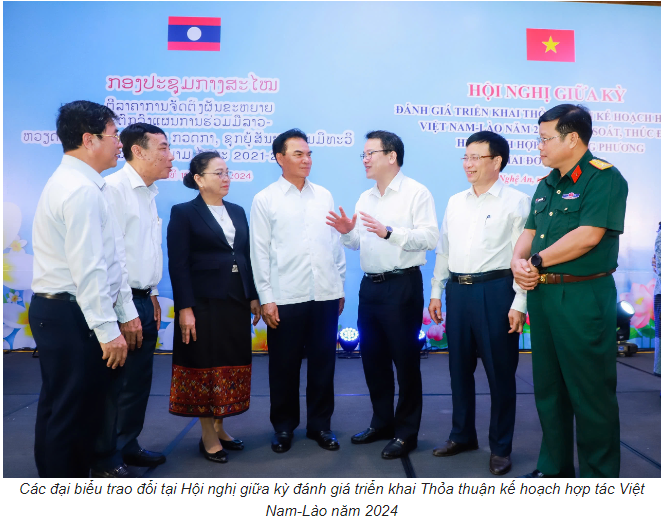

Ảnh minh họa

Công an TPHCM cho biết, thời gian qua đơn vị này cũng liên tục tiếp nhận trình báo của nhiều nạn nhân cầu cứu về việc bị “Deepfake AI” (công nghệ ứng dụng trí tuệ nhân tạo) ghép hình vào clip nhạy cảm, dọa gửi cho người thân quen của nạn nhân trên mạng nhằm mục đích tống tiền.

Mới đây nhất, là trường hợp anh N.H (TP Hồ Chí Minh) đến cơ quan công an trình báo về việc bị một đối tượng trên mạng xã hội sao chép nhiều hình ảnh cá nhân từ trang Facebook và trang Zalo của mình. Đối tượng sử dụng Deepfake AI để ghép clip hoặc hình ảnh nhạy cảm rồi đe dọa gửi cho bạn bè, người quen của anh H trên Facebook, Zalo và tống tiền 150 triệu đồng.

Từ trang cá nhân trên Zalo, Facebook, đối tượng lấy được danh sách bạn bè, người quen của anh H và sử dụng công nghệ Deepfake AI để ghép thành những hình ảnh, clip nhạy cảm. Lúc này, đối tượng đe dọa sẽ gửi các clip, hình ảnh nhạy cảm đến danh sách người quen của anh H, buộc anh này phải chuyển 150 triệu đồng để đổi lấy việc đối tượng không phát các clip, hình ảnh nhạy cảm đó. Do không có tiền để chuyển cho đối tượng, bị làm phiền nhiều lần nên anh H. quyết định trình báo vụ việc đến cơ quan công an.

Một trường hợp khác là anh HVK (trú tại quận Gò Vấp). Anh K cũng từng có thời gian hoảng loạn vì bỗng dưng trở thành nạn nhân của công nghệ Deepfake. Cụ thể, vào một ngày, anh K nhận được tấm ảnh gửi qua messenger (ứng dụng nhắn tin, gọi điện của Facebook), khi mở ra thì anh tá hỏa vì đó là tấm hình mình đang khỏa thân. Người gửi anh K tấm ảnh này yêu cầu anh chuyển khoản 5 triệu đồng nếu không sẽ gửi hình ảnh này cho bạn bè của anh trên mạng xã hội.

Tìm hiểu về hình thức này, anh HVK cho biết, khuôn mặt anh trên tấm hình này được cắt ghép trong tấm ảnh khỏa thân nêu trên có khả năng bị đối tượng lấy từ ảnh đại diện của anh trên Facebook. “Khi thấy hình ảnh đó, tôi rất sợ. Mặc dù biết đó không phải mình nhưng nếu đối tượng gửi cho bạn bè thì họ sẽ không biết.

5 triệu đồng cũng là số tiền lớn với tôi nên tôi nhắn đối tượng xin hoãn việc chuyển tiền”, anh K kể lại. Sau đó, anh H.V.K. trình báo sự việc với công an. Tuy nhiên, vì địa chỉ IP (Internet Protocol-giao thức Internet) bị giả mạo cho nên việc tìm kiếm người đứng sau vụ tống tiền này rất khó.

Người dân cần nêu cao cảnh giác trước thủ đoạn lừa đảo tinh vi

Khả năng tái tạo giọng nói, khuôn mặt, và hành động của người khác đã mở ra cánh cửa cho nhiều hành vi phi pháp, bao gồm cả việc sử dụng deepfake để lừa đảo và tống tiền.

Cụ thể, các đối tượng xấu có thể tạo ra video hoặc âm thanh giả mạo của nạn nhân, sau đó dùng nó để tống tiền hoặc gây tổn hại đến danh dự, uy tín của họ. Ví dụ, một video Deepfake có thể giả mạo cảnh một người đang tham gia vào một hành vi không đứng đắn, hoặc một bản ghi âm giả có thể tạo ra những lời nói không thật. Sau khi tạo ra những tài liệu giả này, kẻ lừa đảo sẽ liên hệ với nạn nhân, yêu cầu họ trả tiền để ngăn chặn việc phát tán những thông tin giả mạo này trên mạng. Điểm nguy hiểm của deepfake nằm ở chỗ nó có thể dễ dàng lừa dối người xem hoặc người nghe, khiến họ tin rằng những gì họ thấy hoặc nghe là thật.

Công nghệ này đã tiến bộ đến mức mắt thường khó có thể phát hiện ra sự giả mạo. Điều này đặc biệt nguy hiểm trong bối cảnh lừa đảo và tống tiền, nơi mà một bằng chứng hình ảnh hoặc âm thanh giả mạo có thể khiến nạn nhân hoang mang, sợ hãi và chấp nhận trả tiền để tránh bị bôi nhọ hoặc tiết lộ thông tin.

Một số nạn nhân còn bị các tổ chức lừa đảo giả danh là thám tử tư gọi điện thoại thông báo về việc phát hiện người này có mối quan hệ bất chính với những người phụ nữ khác. Đối tượng gửi cho nạn nhân các hình ảnh nhạy cảm đã được chỉnh sửa, cắt ghép có sử dụng hình ảnh khuôn mặt của nạn nhân.

Sau đó, các đối tượng lừa đảo yêu cầu nạn nhân phải chuyển một khoản tiền điện tử với giá trị tương đương hàng tỷ đồng vào ví điện tử để không bị đăng lên mạng xã hội. Khi nạn nhân bị ‘sập bẫy’, các đối tượng sẽ hướng dẫn mua tiền điện tử, chuyển đến các tài khoản ví điện tử theo chỉ định để chiếm đoạt.

Cùng với khuyến cáo người dân nâng cao cảnh giác, Trung tâm xử lý tin giả, thông tin xấu độc Việt Nam cũng lưu ý về một số biện pháp phòng ngừa: Cẩn trọng với những yêu cầu kết bạn từ người lạ trên mạng xã hội; không chia sẻ thông tin cá nhân, hình ảnh, video riêng tư với người không quen biết; kiểm tra kỹ nguồn gốc thông tin, hình ảnh, video trước khi chia sẻ.

Ngoài ra, khi phát hiện các trường hợp nghi ngờ lừa đảo, tống tiền bằng Deepfake, người dân cần báo ngay cho cơ quan chức năng. Trường hợp người dân đã trở thành nạn nhân của hình thức lừa đảo, tống tiền bằng hình ảnh, video giả mạo được tạo ra từ việc sử dụng công nghệ Deepfake, Trung tâm xử lý tin giả, thông tin xấu độc Việt Nam khuyên người dân giữ lại tất cả bằng chứng liên quan như tin nhắn, email, hình ảnh, video...; không chuyển tiền cho kẻ tống tiền và liên hệ ngay với cơ quan công an gần nhất để được hỗ trợ.

Việc sử dụng Deepfake để lừa đảo và tống tiền là vô cùng nghiêm trọng. Nạn nhân không chỉ mất tiền mà còn có thể bị tổn hại về danh dự, uy tín. Các vụ việc này còn tạo ra sự hoang mang trong cộng đồng, làm mất lòng tin vào các nội dung trên mạng xã hội và các phương tiện truyền thông.

Tin mới

-

Thứ trưởng Bộ Kế hoạch và Đầu tư Trần Quốc Phương nhấn mạnh, chính sách nhất quán của...26/08/2024 08:15

-

Giảm 50% phí trước bạ với ô tô sản xuất trong nước trong 3 tháng

Thường trực Chính phủ đã thống nhất giảm 50% phí trước bạ với ô tô sản xuất, lắp...26/08/2024 08:51 -

PV GAS tham gia chương trình tri ân “Về nơi khởi nguồn”

Vừa qua, tại Khu di tích quốc gia đặc biệt rừng Trần Hưng Đạo, xã Tam Kim, huyện...25/08/2024 12:08 -

VPBank cung cấp nhiều giải pháp sáng tạo giúp doanh nghiệp quản lý dòng tiền tối ưu

Nhiều nghiên cứu đã chỉ ra rằng, với cùng xuất phát điểm và nguồn lực đầu tư ban...23/08/2024 15:31 -

Forbes vinh danh Vietjet trong danh sách 50 công ty niêm yết tốt nhất Việt Nam 2024

Tạp chí Forbes Việt Nam vừa vinh danh và trao giải cho 50 công ty niêm yết tốt...23/08/2024 15:36 -

Chuyển đổi số là cuộc cách mạng về thay đổi hơn là cuộc cách mạng về công nghệ

Chuyển đổi số là cuộc cách mạng về thay đổi hơn là cuộc cách mạng về công nghệ....23/08/2024 15:45 -

Ứng dụng Microsoft trên Mac chứa nhiều lỗ hổng bảo mật

Ứng dụng Microsoft có lỗ hổng bảo mật nghiêm trọng trên macOS có thể bị tin tặc khai...23/08/2024 15:17 -

SeABank chốt quyền chia cổ tức bằng cổ phiếu và nhận cổ phiếu phát hành tổng tỷ lệ gần 13,6%

Ngân hàng TMCP Đông Nam Á (SeABank, HOSE: SSB) vừa có thông báo chốt danh sách cổ đông...23/08/2024 09:07 -

Tọa đàm trực tuyến ‘Năng suất xanh - nền tảng cho phát triển bền vững’

Tọa đàm trực tuyến với chủ đề “Năng suất xanh - nền tảng cho phát triển bền vững”...23/08/2024 09:15 -

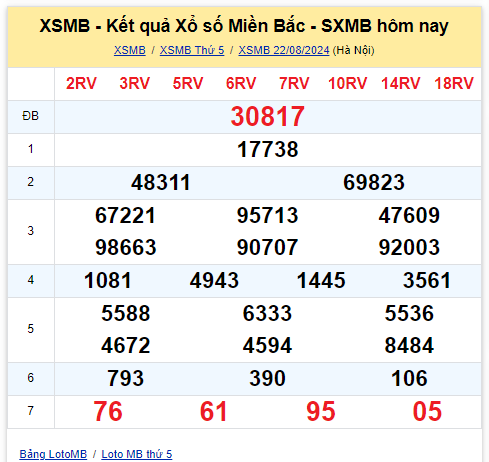

Dự đoán XSMB 23/8 - Dự đoán Xổ Số Miền Bắc 23/8/2024 MIỄN PHÍ

Dự đoán XSMB 23/8/2024 - Soi cầu dự đoán XSMB VIP đẹp hôm nay Dự đoán XSMB 23/8...23/08/2024 08:08 -

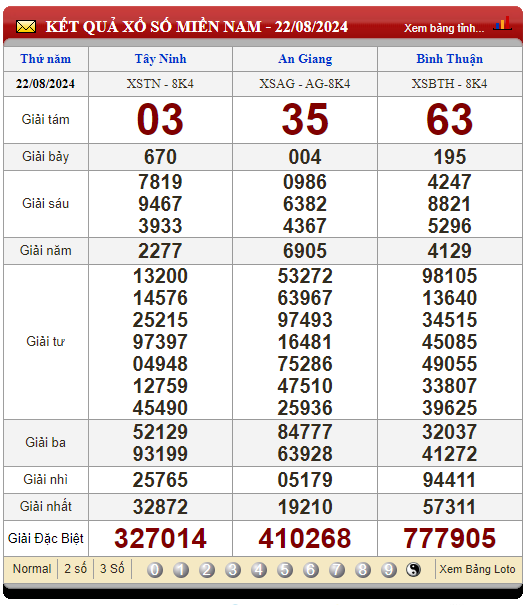

Dự đoán XSMN 23/8 - Dự đoán Xổ Số Miền Nam 23/8/2024 MIỄN PHÍ

Phân tích XSMN 23/8/2024 - Thống kê xổ số Miền Nam ngày 23 tháng 8 năm 2024 thứ...23/08/2024 08:16 -

Dự đoán XSMT 23/8 - Dự đoán Xổ Số Miền Trung 23/8/2024 MIỄN PHÍ

Thống kê xổ số Miền Trung 23/8/2024 - Phân tích XSMT ngày 23 tháng 8 năm 2024 hôm...23/08/2024 08:00 -

Hoa Kỳ khởi xướng rà soát hành chính một số sản phẩm của Việt Nam đang bị áp thuế chống bán phá giá/chống trợ cấp

Bộ Thương mại Hoa Kỳ (DOC) đã đăng thông báo khởi xướng rà soát hành chính đối với...22/08/2024 09:21 -

Việt Nam có nhiều lợi thế trong phát triển trí tuệ nhân tạo AI

Việt Nam có nhiều lợi thế trong phát triển trí tuệ nhân tạo AI, nhờ vào thị trường,...22/08/2024 09:03

404

Thuật ngữ

Thuật ngữ